バーチャルYouTuberを作ろう!!【バーチャル月子さんを制作してみた!】

どうも、ヤミツキテレビの編集担当、闇島です。

最近、YOUTUBE界隈は空前の「バーチャルYouTuberブーム」ですね!

ものすごい数のバーチャルYouTuberが連日生まれています。

3Dモデルを制作しモーションキャプチャーを駆使して動画を制作している本格派YouTuberから、2Dモデルを制作しフェイスリグでフェイスモーションキャプチャーで手軽にライブチャットを行っているYouTuberもいます。

特に2DモデルのバーチャルYouTuberは、その手軽さと初期費用の安さから参入する人が多く大多数の新規バーチャルYouTuberは2Dモデルで制作されています。

すでにデジタルイラストを制作する環境を持っている人であれば

・Live2D Cubism3

・FaceRig(フェイスリグ)

・FaceRig Live2D Module

を導入するだけでできるの手軽に参入することができます。

さて、そんな一大ムーブメントが起きているバーチャルYouTuber界に、ヤミツキテレビも参入できないか・・・2DモデルのバーチャルYouTuberなら自分でも制作できるかも知れない!と思ったので一念発起して制作してみました。

ここでは、その制作過程を簡単に書いていきたいと思います。

目次

1.必要なものを揃えよう!!

まずは、必要なものを揃えます。

(デジタルイラストを制作する環境があること前提です)

・PSD(Photoshop形式ファイル)が出力できるイラストソフト

LIVE2Dに作画データを読み込ませる時にPSDファイルが必要になるので、これがないと始まりません。

・Live2D Cubism3(http://www.live2d.com/ja/)

2Dの絵のアニメーションを作るためのソフトです。

Live2D Cubism2、Live2D Cubism3のフリー版があります。自分はLive2D Cubism3で制作しました。

ただし、フェイスリグはLive2D Cubism2の2.0形式に対応しているので、制作して出力する際はモデルデータ、パワメータデータ、モーションデータは2.0形式で出力しなければいけません。

3.0には2.0形式で出力する機能があります。

ただ、物理演算は2.0専用の「Live2D Viewer」で制作しなければいけません。

・FaceRig(フェイスリグ)

ウェブカメラで顔の動きを認識し、キャラの顔と同期させてキャラの顔を動かすソフトです。

フェイスリグを購入するには、Steamに登録してからSteam内で購入する必要があります。

(https://store.steampowered.com/app/274920/FaceRig/?l=japanese)

また、FaceRig Live2D Module を購入しないと、LIVE2DのデータをFaceRigで使用することはできませんので注意。

・ウェブカメラ

ノートパソコンのカメラとかでも出来ます。

2.キャラクターデザインを考えよう!!

キャラクターデザインはあまり得意な方ではないのですが・・・月子さんのキャラクターにマッチしたデザインを考えるため5~7個くらいのキャラクターデザイン案を考えました。

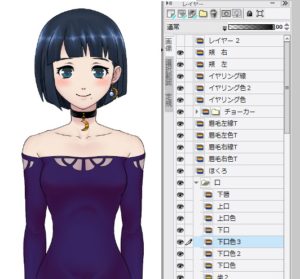

最終的に決まったデザインのラフがこちら。

月子さんはやはり落ち着いた性格、癒やしボイスが特徴なので、大人の印象を残しつつ可愛いデザインをイメージしました。

服装は他のVtuberを参考にしつつ、肩出しルックは大人っぽくて良いのではないかと思い採用しました。(ちなみに、この後宇宙服とか和服とか複数の服をデザインして実装してます)

3.イラストを制作しよう!!

イラストデータを制作します。

ただし普通に一枚絵を書くのではなく、LIVE2Dに適合したデジタルデータを制作しなければなりません。

LIVE2Dは、顔・腕・身体・目・口・鼻・耳・・・等、パーツ毎にアートメッシュを割当て変形させたり動かしたりするソフトです。

ですので、こんな感じで一枚絵に見えても多層レイヤーで構成されたデータを作る必要があります。

LIVE2Dの公式サイトで参考にできるデータが配布されているので、そちらを参考にしながら制作することをオススメします。

4.LIVE2Dで動かしてみよう!

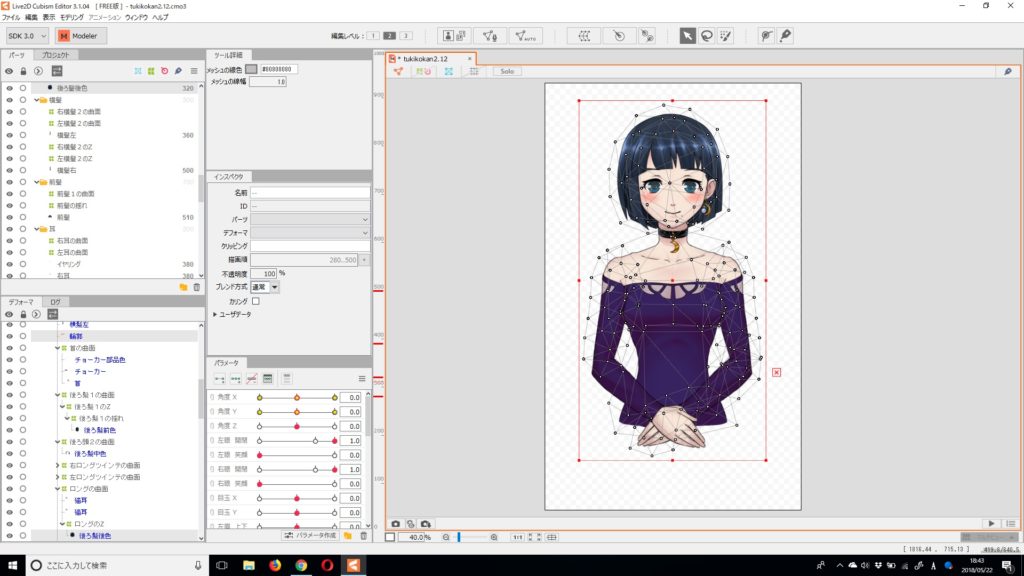

制作したデータをPSD形式で出力し、LIVE2Dで読み込み。

レイヤー毎にアートメッシュを制作し、動作できるようにします。

画像のようにイラストにアートメッシュが割り当てられているのがわかると思います。

このアートメッシュをいじったり、デフォーマーなどを変形させ、目を閉じたり開いたり、首を傾けたり、振り向かせたりします。

ただ、全部調整していると面倒なので、「テンプレートを適用」で一連の動作を適用できるのでこちらで調整しましょう。

ここでの調整は結構戸惑うと思います・・・っていうか、戸惑いました。

それぞれのパーツを、テンプレートと同じパラメータに適合する必要があります。

面倒ですが、目には目を、前髪には前髪のパラメータを適合させましょう。

これは、結構戸惑いました。

さて、テンプレートを適用してそれぞれのパーツにアートメッシュが設定され、動作も適応されたと思います。

しかし、まだ表には出せるようにはなりません。

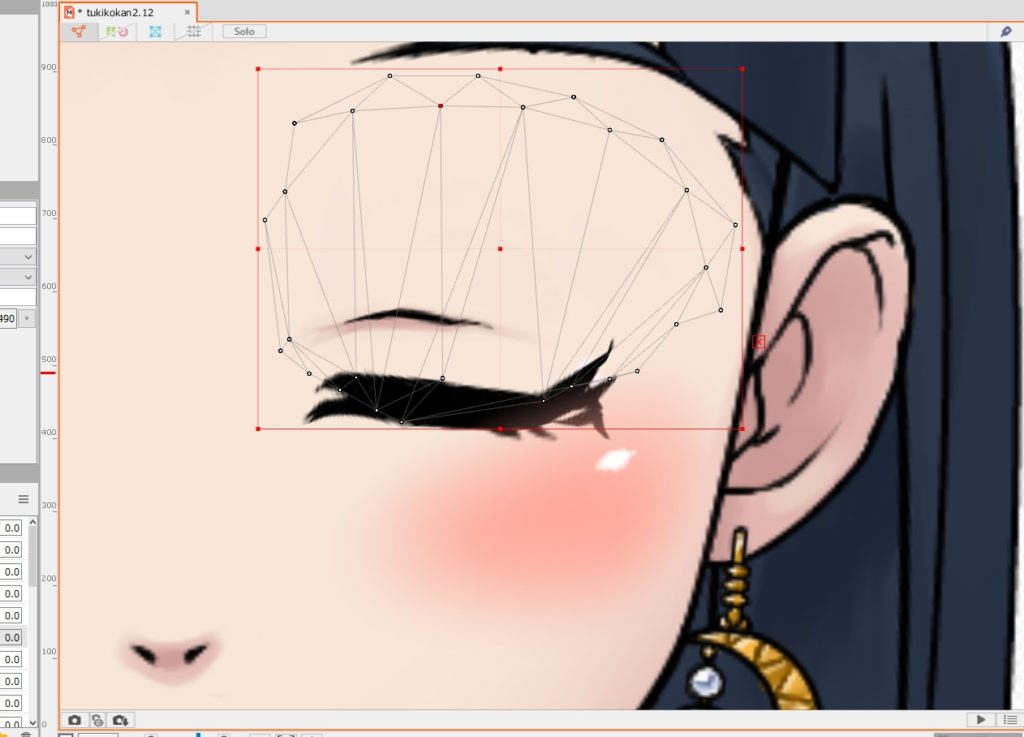

下記画像のように、目を閉じると瞳がまぶたの上に出てきてしまったりしていると思います。

この場合は、描画順という項目がありますので、描画順位を調整します。

まぶたを描画順500、瞳を描画順490とかにすると、右のように隠れます。

それでもはみ出る時がありますが、その時は、アートメッシュをイジって隠しましょう。

どんどん調整していきましょう!

動作確認を行って、細かいところを調整しましょう

ちなみにイヤリングとか、髪とか自然に揺らしたいと思ったら「物理演算データ」を取り入れましょう

ただ、「Live2D Cubism3」内にある「Live2D Viewer」で物理演算データを作ってもフェイスリグは「2.0形式のLive2D Viewer」で制作しなければデータファイルが読み込まれません。

Live2D Viewer(http://sites.cybernoids.jp/cubism2/tools/live2d-viewer)

物理演算の調整はそこまで難しいものではないので、感覚でできると思います。

ここからは、個人的にかなり混乱した部分ですが・・・

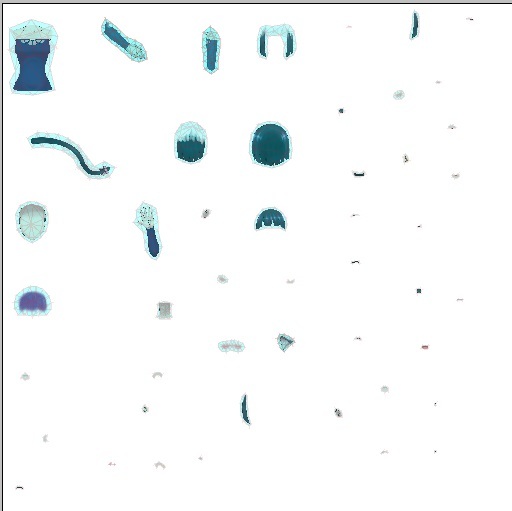

調整が終わったらフェイスリグで使用するためにデータを出力するのですが、そのためにまず「テクスチャアトラス」を生成する必要があります。

テクスチャアトラスを自動生成するとこんな感じのファイルが出来ます。

しかし、自動生成するとデータを極限まで圧縮してしまうんです。

そのため、下の画像のようにモデルの画質がかなり荒くなってしまいます。

ですので、面倒ですがなるべく画質を良くするためにそれぞれの画像を大きく表示できるようにパーツを拡大して画面いっぱい使うようにしましょう

(ちなみに、LIVE2Dのフリー版の場合は生成できるテスクチャアトラスは2048×2048で一枚だけです。月子さんを作った時は、1ヶ月トライアル版にしてテスクチャ枚数を無制限にしたので5枚に落とし込みました)

テスクチャアトラスを生成できたら、【mocファイル書き出し(2.1用)】でmocファイルを生成します。

・mocファイル

・model.jsonファイル

・テクスチャファイル

が出力されるので、一つのファイル(ファイル名は必ず英数字で!)にまとめます。

物理演算データ(physics.jsonファイル)を制作した場合は同じフォルダに入れると自動で適応します。

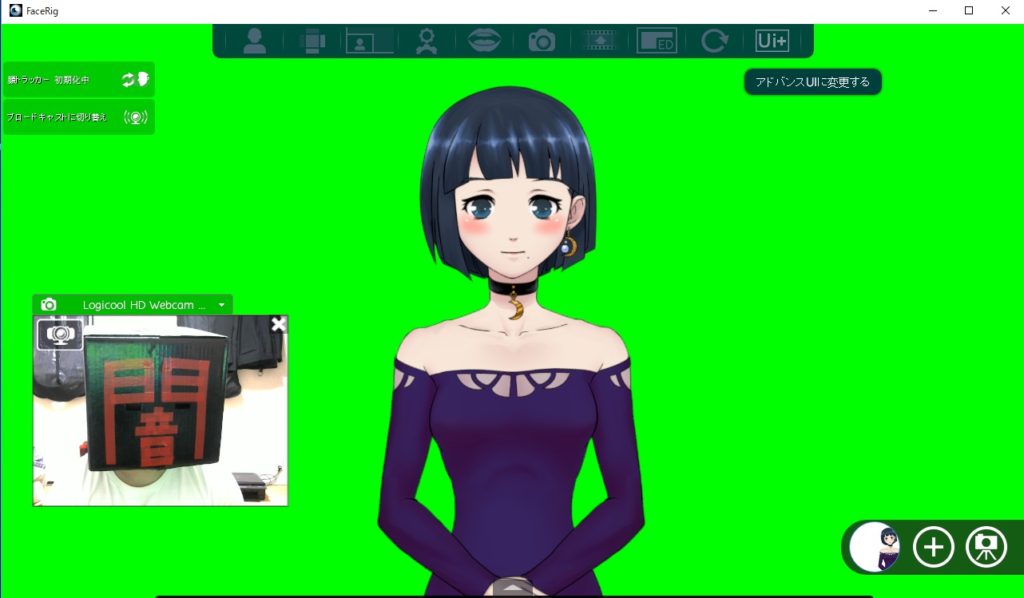

5.FaceRig(フェイスリグ)に取り込もう!

SteamでFaceRig(フェイスリグ)を購入して、制作したmocファイルのフォルダを

ProgramFiles→Steam→steamapps→common→FaceRig→Mod→VP→PC_CustomData→Objectsで「Objects」フォルダを開き、そこに制作したmocファイルのフォルダを入れてください。

入れ込んだらフェイスリグを起動し、データが反映されていることを確認してください。

こんな感じで表示されて、ちゃんと動作したら完成です!

個人的に迷った部分などは、詳しく書きましたがザックリとこんな流れで制作できました。

バーチャルYouTuberをこれから始めたいという方の少しでも参考になればと思います。

わからないことは、とにかくGOOGLEで検索しまくりましょう。

特殊な名称とかも沢山でてくるので、LIVE2Dは飲み込むまで時間かかると思います。

が、自分のイラストが生き生きと動くのはものすごい感動がありますよ!!

ぜひぜひチャレンジしてみてください!

では、闇島でした!

ディスカッション

コメント一覧

まだ、コメントがありません